大家好,这里是我们组织的新栏目:RWKV 社区最新动态,这个栏目会不定期播报 RWKV 社区的最新消息,以帮助 RWKV 的关注者、爱好者、开发者更好地了解 RWKV 的发展情况。

《RWKV 社区最新动态》是不定期更新,所以请保持关注我们的公众号(RWKV 元始智能)、QQ 频道(RWKV)等公开的消息平台,以获取最新的消息。

本期节目统计了 RWKV 社区 5 月的重要动态:

RWKV 中文文档(测试版)已上线

RWKV 中文文档 https://rwkv.cn/docs 已上线。

当前文档涵盖了 RWKV 百科、RWKV 模型微调、RWKV 本地部署和推理工具 RWKV Runner 和 Ai00 的使用教程。

RWKV 中文文档处于测试阶段,后续会继续完善内容并更新视觉风格,欢迎大家对文档提出改进意见。

寻找基于 RWKV 的项目

RWKV Foundation 想感谢大家对 RWKV 大模型的支持。我们特别准备了一些周边礼品,作为小小心意~

如果你曾经或正在使用 RWKV 大模型进行开源或商业项目的开发,请与我们联系!

(可以在下方留言或私信我们的微信公众号,告诉我们你的联系方式和项目信息。

RWKV 参加澳门 BEYOND EXPO

5 月 23 – 25 日,作为 NVIDIA Inception Program 成员之一, RWKV 受邀参加第四届 BEYOND 国际科技创新博览会(BEYOND Expo 2024),在大会现场中展示了 RWKV AI 作曲工具和 RWKV-6 7B 语言模型。

RWKV 作曲家兼顾生产力和趣味性,就连澳门特首都被动听的旋律吸引而来:

新微调方法:State tuning

RWKV 推出了新的微调方法:state tuning。

RWKV 是纯 RNN,因此可以做 transformer 难以做到的事情。例如,作为 RNN 有固定大小的 state,所以,微调 RWKV 的初始 state,就相当于最彻底的 prompt tuning,甚至可以用于 alignment,因为迁移能力很强。

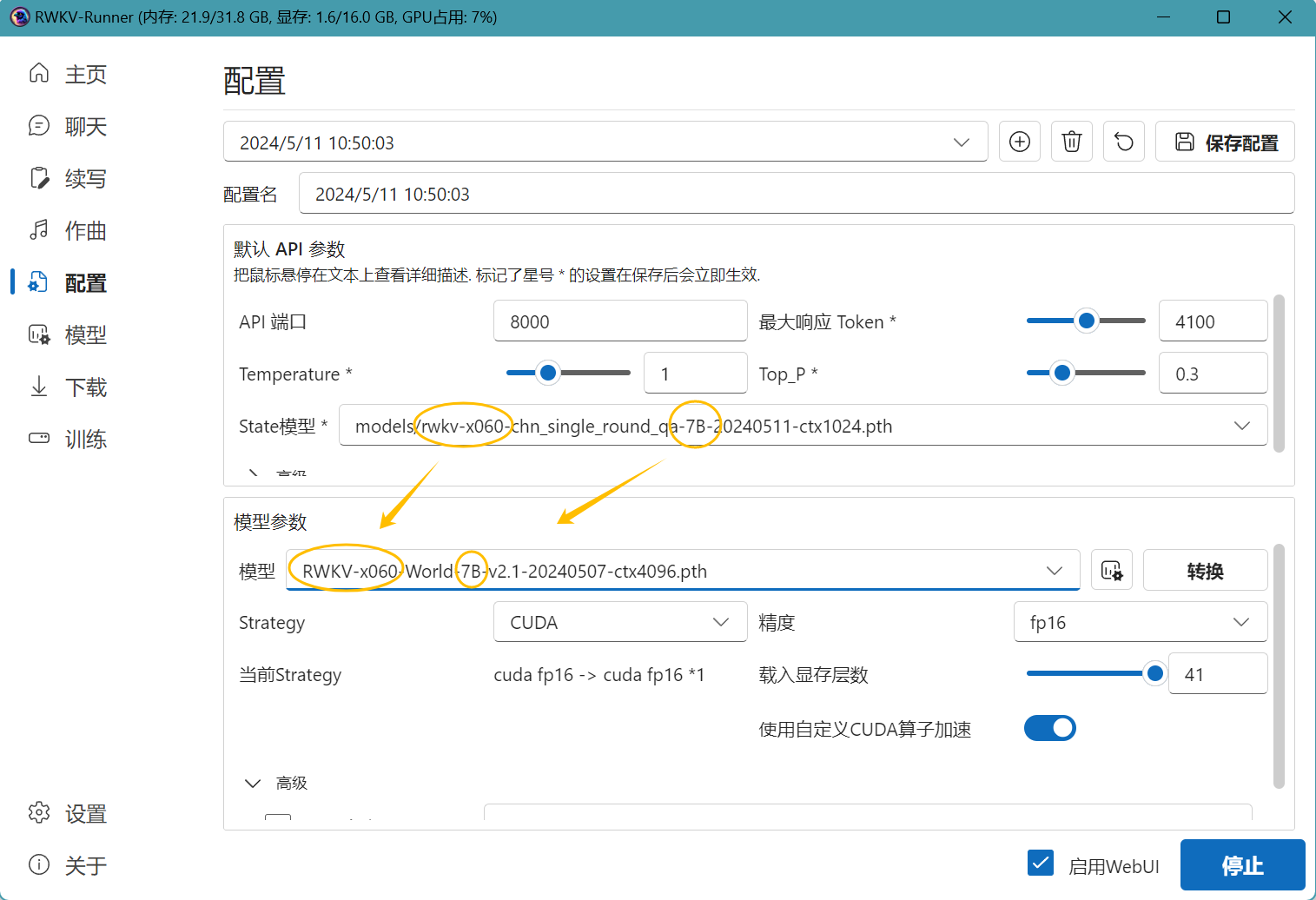

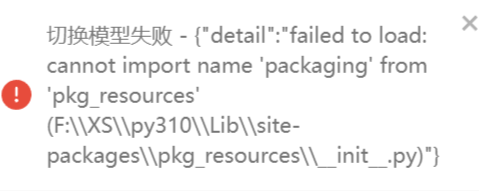

目前 RWKV Runner 和 Ai00 等 RWKV 模型推理工具都已支持挂载 state tuning 训练得到的 state 文件。

注意:挂载 state 文件时,必须使用训练该 state 文件的同款 RWKV 模型。

举个例子:这个 state 文件是基于 RWKV-6-World-7B-v2.1 模型微调而来,那么你在 RWKV Runner 或 Ai00 等工具中必须启动 RWKV-6-World-7B-v2.1 模型,挂载的 state 文件才会生效。

我们正在准备 RWKV state tuning 的教程,很快会为大家呈现!

RWKV 的 MMLU 数据

社区开发者在 FP16 下测试了 RWKV-6-World-7B-v2.1 模型的 benchmark, 得到以下数据:

作为对比, llama2 7B MMLU 数据为 45.3%。

RWKV 社区新项目/项目更新

新的多模态项目:PointRWKV

PointRWKV 项目是一种基于 RWKV 的 3D 点云学习框架,在下游点云任务上性能优于基于 Transformer 和 Mamba 的同类工作,显著节省了约 46% 的 FLOPS。

PointRWKV 项目由腾讯优图主导,计划逐步开源。

可以从下面的链接了解 PointRWKV :

论文链接:https://arxiv.org/pdf/2405.15214 《PointRWKV: Efficient RWKV-Like Model for Hierarchical Point Cloud Learning 》

仓库地址:https://github.com/hithqd/PointRWKV

新项目:RWKV_LM_EXT

RWKV_LM_EXT 旨在扩展 RWKV LM 的功能,包括序列分类/嵌入/peft/交叉编码器/双编码器/多模态等。

仓库地址:https://github.com/yynil/RWKV_LM_EXT

RWKV Runner 发布新版本

RWKV Runner 在 5 月发布了 v1.8.0 ~ v1.8.4 五个版本,其中需要注意的改进:

Ai00 发布新版本

RWKV Runner 在 5 月发布了 v0.4.7 ~ v0.5.1 五个版本,其中需要注意的改进:

Ai00 新功能的详情可以参考:https://ai00-x.github.io/ai00_server/doc-guide/features

RWKV-PEFT 发布新微调方法

RWKV-PEFT 是 RWKV 模型的微调仓库,包含 Pissa、Lisa、Lora、State tuning 等多种微调方法。

RWKV-PEFT 在 5 月更新了 infctx train、State tunin、FLA(Flash Linear Attention) 等内容,更多细节可以在仓库中查看。

RWKV-PEFT 仓库地址:https://github.com/JL-er/RWKV-PEFT

6 月动态预告

RWKV-6 14B 即将发布

RWKV-6 14B 模型预计在 6 月中旬完成训练并开源发布。

RWKV 6 月线上分享会

6 月中旬我们将开展一场线上分享会,会上将包含 RWKV-6 架构,RWKV-TS、Vision RWKV、Diffusion RWKV、RWKV-ASR 等 RWKV 多模态的论文分享和解析。

会议还包含了 RWKV 答疑环节,如果你想在分享会上进一步了解 RWKV 的架构、多模态工作等生态内容,可以关注我们的官方频道,随时掌握线上分享会的动态!

未经允许不得转载:岩猫星空网 » State 微调、PointRWKV、中文文档上线……RWKV 社区 5 月最新动态来啦!

岩猫星空网

岩猫星空网