OpenAI 推出了一款最新的旗舰生成式 AI 模型 GPT-4o,其中“o”代表“omni”,源自拉丁语“omnis(意为“全能”)”,指的是该模型处理文本、语音和视频的能力。

GPT-4o将在未来几周内向所有免费的 ChatGPT 用户开放,同时还将推出一个 MacOS 版的 ChatGPT 桌面应用程序(稍后将推出 Windows 版),允许用户在网络和移动应用程序之外进行访问。

OpenAI 首席技术官 Mira Murati 表示,GPT-4o 提供了“GPT-4 级别”的智能,但改进了 GPT-4 跨多种模式和媒体的能力。“GPT-4o 可以跨越语音、文本和视觉。这一点非常重要,因为我们正在研究我们自己与机器之间交互的未来。”

根据介绍,GPT-4o 对语音功能进行了增强,提升交互体验。例如,用户可以向 GPT-4o 支持的 ChatGPT 提问,并在 ChatGPT 回答时打断它。 OpenAI 表示,该模型提供“实时”响应能力,甚至可以识别用户声音中的细微差别,从而生成“一系列不同情感风格”(包括唱歌)的声音。

“它可以在短短 232 毫秒内响应音频输入,平均为 320 毫秒,这与人类在对话中的响应时间相似”。而此前 GPT-3.5 语音对话的平均延迟为 2.8 秒、GPT-4 为 5.4秒,音频在输入时还会由于处理方式丢失大量信息,无法识别笑声、歌唱声和情感表达等。

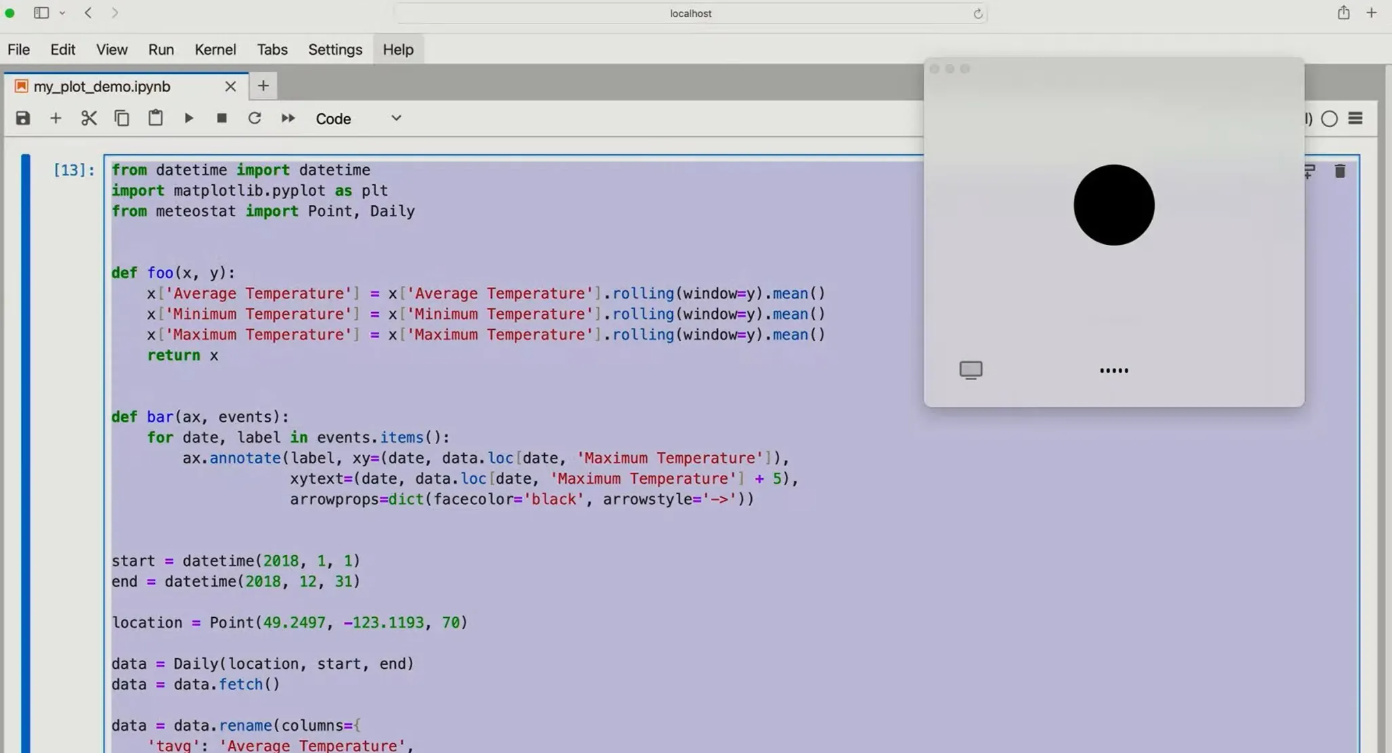

GPT-4o 还升级了 ChatGPT 的视觉能力。给定一张照片或一个 desktop screen,ChatGPT 现在可以快速回答相关问题。

Murati 表示,未来将进一步发展其自然语言、实时语音对话功能;并添加通过实时视频进行 ChatGPT 对话的功能,使 ChatGPT 能够“观看”现场体育赛事并向用户解释规则。

“我们知道这些模型越来越复杂,但我们希望交互体验实际上变得更加自然、轻松,让你完全不用关注用户界面,而只关注与 ChatGPT 的协作。过去几年,我们一直非常专注于提高这些模型的智能性……但这是我们第一次真正在易用性方面向前迈出一大步。”

OpenAI 声称,GPT-4o 还具有更强的多语言能力,可增强约 50 种语言的性能。该公司表示,在 OpenAI 的 API 和微软的 Azure OpenAI 服务中,GPT-4o 的速度是 GPT-4 Turbo 的两倍,价格是后者的一半,速率限制也更高。

OpenAI 计划在未来几周内首先面向“一小部分可信赖的合作伙伴 ”推出对 GPT-4o 新音频功能的支持。

ChatGPT Free 用户在使用 GPT-4o 时将能够访问的功能包括:

未经允许不得转载:岩猫星空网 » OpenAI 发布更快更便宜的 GPT-4o 模型

岩猫星空网

岩猫星空网