在 WWDC24 之前,苹果在 Hugging Face 平台上发布了一个「具有开源训练和推理框架的高效语言模型」,名为 OpenELM。

官方介绍称:大型语言模型的可重复性和透明性对于推进开放研究、确保结果的可信度以及调查数据和模型偏差以及潜在风险至关重要。为此,我们发布了 OpenELM,一个最先进的开源语言模型。

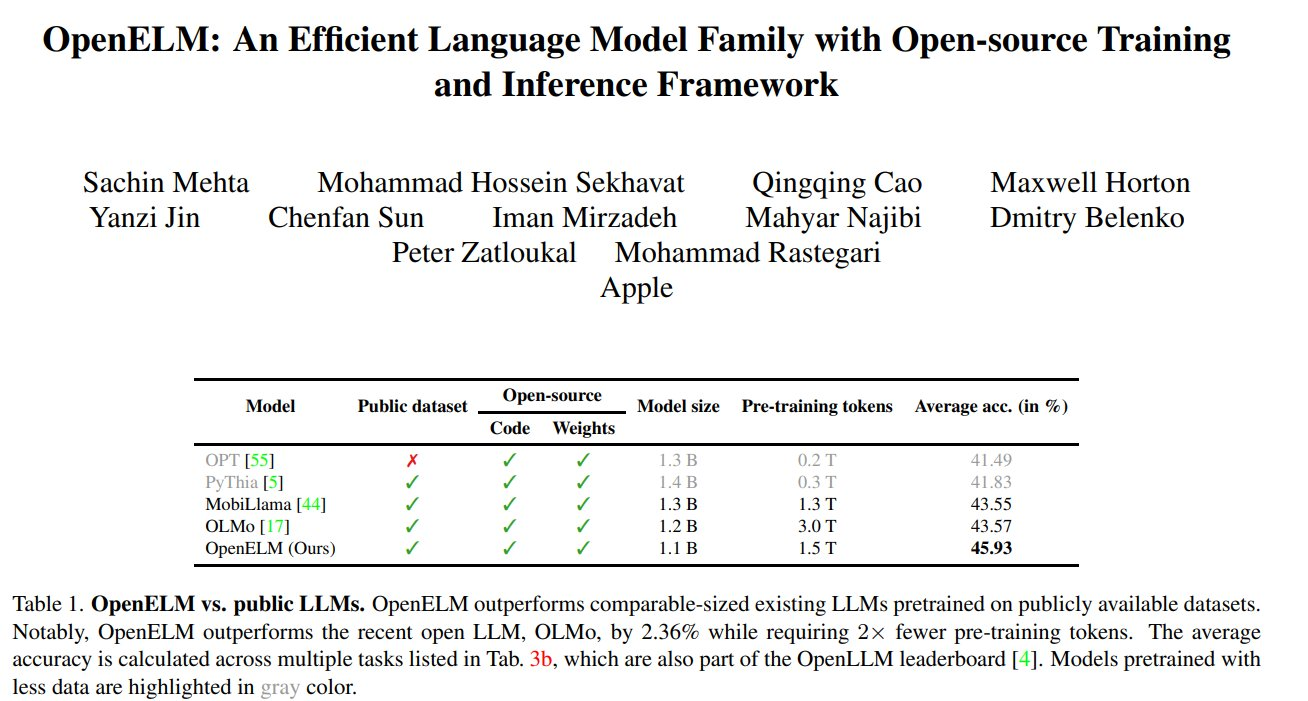

OpenELM 使用分层缩放策略,可以有效地分配 Transformer 模型每一层的参数,从而提高准确率。例如,在参数量约为 10 亿的情况下,OpenELM 与 OLMo 相比准确率提升了 2.36%,同时所需的预训练 tokens 数量仅有原来的 50%。

OpenELM 有四种尺寸:2.7亿、4.5亿、11亿和30亿个参数。而微软Phi-3模型为38亿,因此前者在小型机型上运行成本更低,可在手机和笔记本电脑等移动设备上运行,是做AI硬件的绝佳小模型。

OpenELM 核心特性如下

论文地址:https://arxiv.org/abs/2404.14619 模型地址:https://huggingface.co/apple/OpenELM

未经允许不得转载:岩猫星空网 » 苹果开源面向移动设备打造的小尺寸模型 OpenELM

岩猫星空网

岩猫星空网