马斯克旗下的 AI 初创公司 xAI 宣布了其最新的生成式人工智能模型 Grok-1.5,构建在基于 JAX、Rust 和 Kubernetes 的自定义分布式训练框架之上,能够进行长上下文理解和高级推理。预计在未来几天内面向早期测试人员和 핏 平台上的现有 Grok 用户提供。

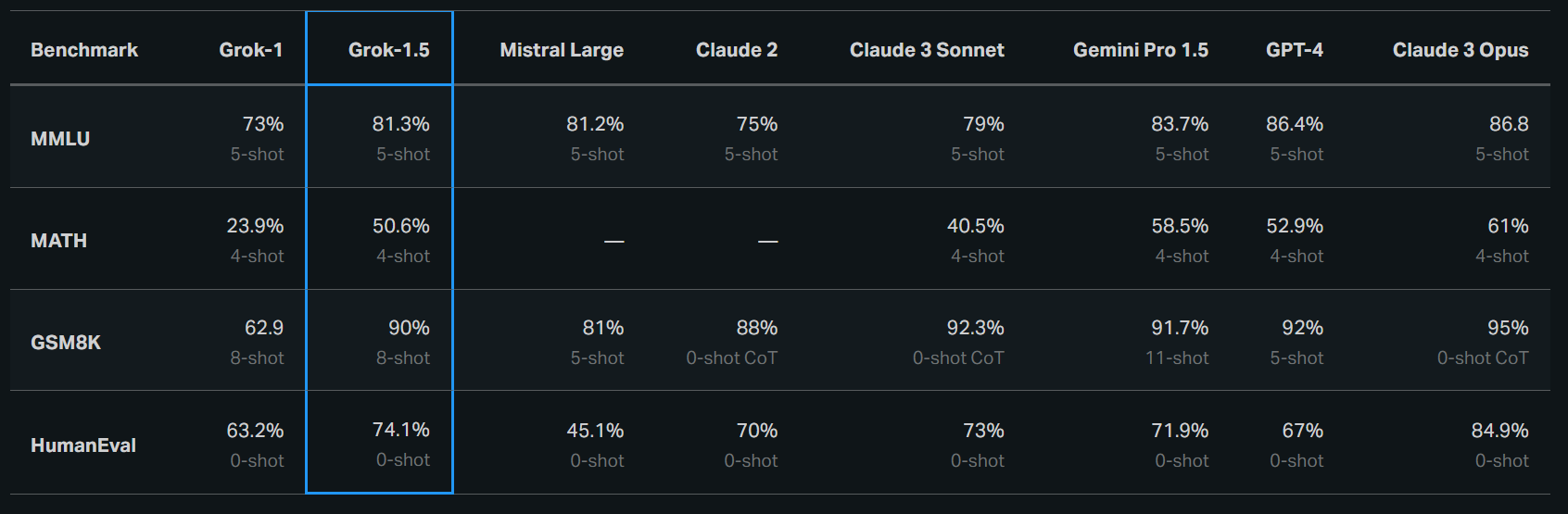

相较前身 Grok-1,Grok-1.5 似乎有了明显的升级。根据 xAI 的说法,Grok-1.5 最显着的改进之一是其在编码和数学相关任务中的性能。在测试中,Grok-1.5 在 MATH 基准上取得了 50.6% 的成绩,比 Grok-1 的得分高出一倍有余;在 GSM8K 基准上取得了 90% 的成绩。

此外,它在评估代码生成和解决问题能力的 HumanEval 基准测试中得分为 74.1%,比 Grok-1 高出十多个百分点;优于除 Claude 3 Opus 之外的所有模型。

在评估 AI 模型跨不同任务的语言理解能力的 MMLU 基准测试中,Grok-1.5 的得分为 81.3%,大幅领先 Grok-1 的 73%。并且超过了最近推出的 Mistral Large(81.2%),但落后于 Gemini 1.5 Pro(83.7%)、GPT-4(86.4%,截至 2023 年 3 月)和 Claude 3 Opus(86.8%)。在 GSM8K 基准测试中,Grok-1.5 的表现也仅次于谷歌、OpenAI 和 Anthropic 的产品。

Grok-1.5 中的一个新功能是能够在其上下文窗口内处理多达 128K 个 token 的长上下文。这使得 Grok 的内存容量增加到之前上下文长度的 16 倍,从而能够利用更长文档中的信息。该模型还能处理更长、更复杂的提示,同时随着上下文窗口的扩大,仍能保持其指令跟踪能力。

马斯克还透露了 Grok 2 相关的信息,表示正在训练中的 Grok 2 将在所有指标上都应该超过当前的 AI,但他并没有透露具体可用的时间。

未经允许不得转载:岩猫星空网 » 马斯克宣布 Grok-1.5,上下文长度至 128K

岩猫星空网

岩猫星空网